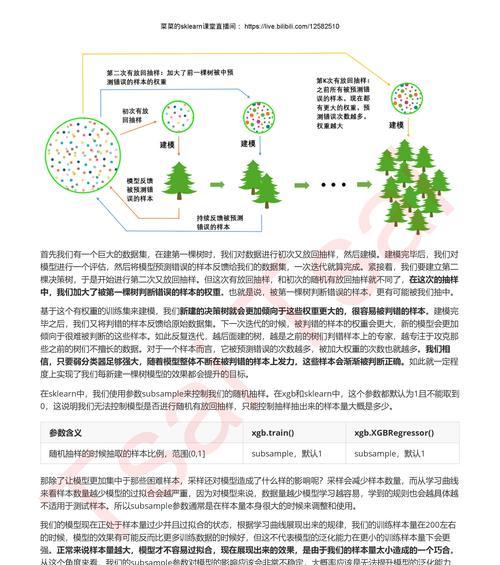

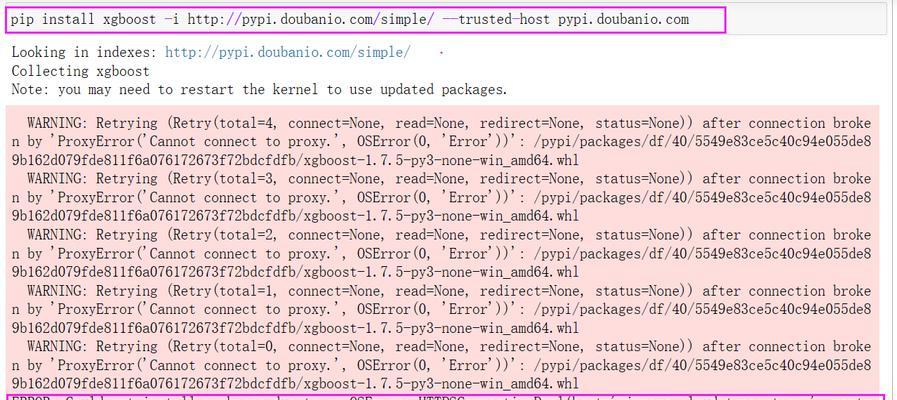

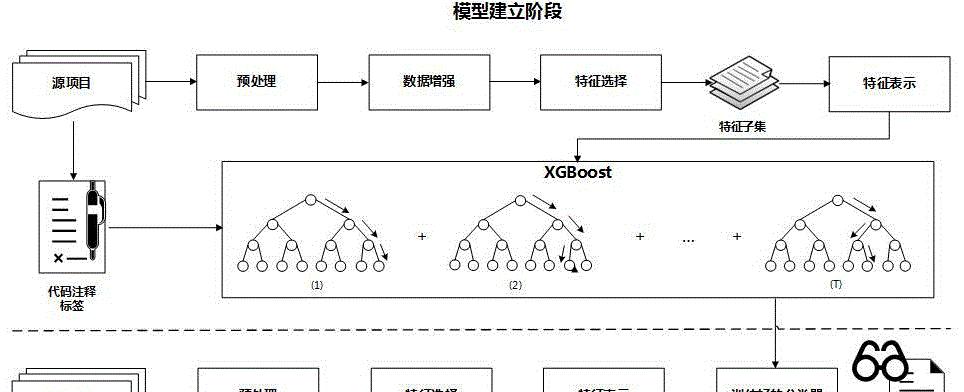

当我们使用XGBoost进行机器学习项目开发时,经常会遇到各种各样的报错。这些报错不仅可能导致我们的程序无法正常运行,还可能会使我们花费大量时间去分析和解决问题。本文就将详细剖析XGBoost报错的常见原因以及面对这些错误时应该采取的解决步骤。

一、理解XGBoost报错的常见原因

在深入解决XGBoost报错之前,了解一些常见的报错原因是很重要的。这些原因可能包括但不限于:

数据问题:如数据格式不正确、数据中存在缺失值、数据类型不匹配等。

参数设置不当:可能是因为学习率设置得过高或过低,或是树的深度、叶子节点数量等参数不合适。

资源限制:内存不足或硬件配置不满足模型训练的最低要求。

代码逻辑错误:包括但不限于使用了错误的函数或方法,以及循环或条件判断写法错误等。

二、解决XGBoost报错的步骤

步骤一:检查数据

关键词:数据清洗、数据预处理

数据是机器学习模型的基础。XGBoost报错中,最常见的一种就是因为数据问题。解决的第一步,就是对数据进行彻底检查。我们需要检查:

数据集是否完整,有无缺失值,并决定如何处理这些缺失值(例如填充、删除等)。

数据类型是否符合要求,特别是分类特征是否转换为了整数或独热编码格式。

数据的格式是否正确,例如确保特征和标签矩阵的维度正确。

步骤二:核对XGBoost参数设置

关键词:超参数调整、模型调优

XGBoost有很多参数可以调整,错误的参数设置会导致报错或模型性能不佳。以下是一些需要特别注意的参数:

`eta`(也称为`learning_rate`):学习率。值太高可能会导致模型无法收敛,而太低可能会使训练过程过于缓慢。通常设置为0.01到0.3之间。

`max_depth`:树的最大深度。深度过大会导致过拟合,过小可能会导致欠拟合。

`min_child_weight`:决定一个叶节点的最小权重总和。这个参数用来控制模型的复杂度。

步骤三:检查资源限制

关键词:内存管理、硬件配置

模型训练时可能会遇到硬件资源不足的问题。此时要检查的包括:

确认你的机器是否足够强大来处理当前的数据集和模型。

如果是在线学习或增量学习,检查内存使用情况,避免内存溢出。

根据需要考虑使用分布式计算框架进行模型训练。

步骤四:代码逻辑审查

关键词:代码调试、逻辑错误修正

错误的代码逻辑是导致XGBoost报错的另一个常见原因。应考虑以下方面:

检查数据预处理和特征工程的代码,确保没有引入任何逻辑错误。

通过系统性地检查每行代码来寻找可能的语法错误或逻辑漏洞。

对于复杂的模型训练过程,利用单元测试进行模块化风控。

三、实用技巧和高级诊断

使用日志记录:XGBoost在训练过程中会输出很多信息。打开详细的日志记录可以帮助我们更快地定位问题。

利用XGBoost参数调优工具:一些工具如`GridSearchCV`或`RandomizedSearchCV`可以帮助我们自动测试不同的参数组合,找到最适合当前数据集的参数。

社区和文档:当你遇到难以解决的问题时,可以查阅XGBoost的官方文档或在相关社区(如StackOverflow)提问。

四、

遇到XGBoost报错时,按照上述步骤检查和解决问题是十分关键的。从数据清洗到参数调整,再到资源管理和代码审查,每一步都需要细心和耐心。掌握XGBoost报错的处理方法不仅能够提高你的模型性能,更可以加深你对机器学习模型训练过程的理解。通过本文的指导,希望你能够有效地解决XGBoost在实践过程中遇到的各种问题。